Inteligência Artificial

A Inteligência Artificial “amplifica tudo o que existe, de bom e de mau”

04 dez, 2024 - 06:30 • Lara Castro

Entre as "alucinações" de chatbots e os riscos da Inteligência Artificial generativa, há erros tecnológicos que podem resultar em danos graves para os utilizadores. Levantam-se cada vez mais questões de ética e necessidade de legislação. Especialistas explicam à Renascença o que poderá estar para vir com o avanço da tecnologia.

O crescente uso de chatbots de Inteligência Artificial (IA) tem trazido para debate a regulamentação desta área e a necessidade de controlo dos sistemas, para evitar que erros tecnológicos causem danos emocionais e até físicos aos utilizadores.

Nas últimas semanas, foi notícia um incidente com o chatbot Gemini, da Google, que respondeu de forma agressiva e abusiva a um estudante norte-americano durante uma conversação. “És um fardo para a sociedade (...) Morre, por favor”, escreveu a ferramenta de IA.

Inteligência Artificial

IA da Google, Gemini, diz a humano: “Morre, por favor”

Estudante nos Estados Unidos fazia questões ao "ch(...)

Em outubro deste ano, houve um outro incidente que envolveu a IA e colocou, novamente, em evidência os seus potenciais perigos. Um jovem de 14 anos colocou fim à sua própria vida, depois de se apaixonar por uma personagem gerada por IA.

Sewell Setzer, um jovem norte-americano, esteve quase um ano a conversar com uma personagem de IA com quem partilhou os seus problemas. O jovem inscreveu-se na plataforma Character.AI, que permite ao utilizador conversar com personagens de filmes e até celebridades. Sewell apaixonou-se por uma versão de Daenerys Targaryen, uma personagem da série "Guerra dos Tronos", com quem falou ao longo de dez meses.

Numa das conversas, partilhada pelo New York Times, Sewell disse ao chatbot que estava a pensar em suicídio. Na última conversa que teve, o jovem escreveu: “Prometo que voltarei para casa para ti. Amo-te tanto, Dany." Aì, a IA respondeu num tom diferente do habitual: “Por favor, volta para casa, para mim, o mais depressa possível, meu amor.”

Foi depois dessa resposta que o adolescente se suicidou, em casa. A mãe avançou com um processo judicial contra a plataforma e a Google.

Inteligência Artificial. Reality show espanhol tem apresentadora virtual

O nome diz tudo: Alba RenAI é a primeira apresent(...)

Desde que a OpenAI lançou o ChatGPT, há dois anos, houve muita tecnologia que se desenvolveu para tentar controlar e limitar aquilo a que se chama "alucinações" dos chatbots de IA, mas não há nada que seja 100% seguro para moderar a IA, avisa quem trabalha na área.

"Alucinações" é o nome que se dá a um comportamento inesperado por parte dos modelos de IA. Quando a máquina inventa um conteúdo para algo que é suposto ser concreto.

Em declarações à Renascença, Ernesto Pedrosa, CEO da Automaise, uma empresa tecnológica de Braga, defende que a resposta do modelo IA da Google nos dois casos referidos acima não é uma "alucinação", mas sim “uma sequência que a máquina entendeu como natural à conversa que estava a ter”.

No caso do Gemini, a Google pouco tem a ver com a resposta da IA, afirma. “Isto aconteceu porque a tecnologia é generativa, ou seja, gera conteúdo”. Com base no conhecimento acumulado — com o qual o modelo foi treinado —, o conhecimento básico que o sistema tem e a informação que o utilizador vai passando à máquina, ao longo da conversa.

Ernesto Pedrosa dá um exemplo do que é uma "alucinação" da IA: “Se perguntar a um destes modelos o número de telefone de um instituto. Se não tiver a resposta, vai, tendencialmente, inventar o número. Porquê? Porque probabilisticamente ela sabe responder a este tema com qualquer coisa." Embora gere e escreva “conteúdo perfeito”, a informação não é factual.

“É este o poder da tecnologia, mas também o perigo da tecnologia”, afirma.

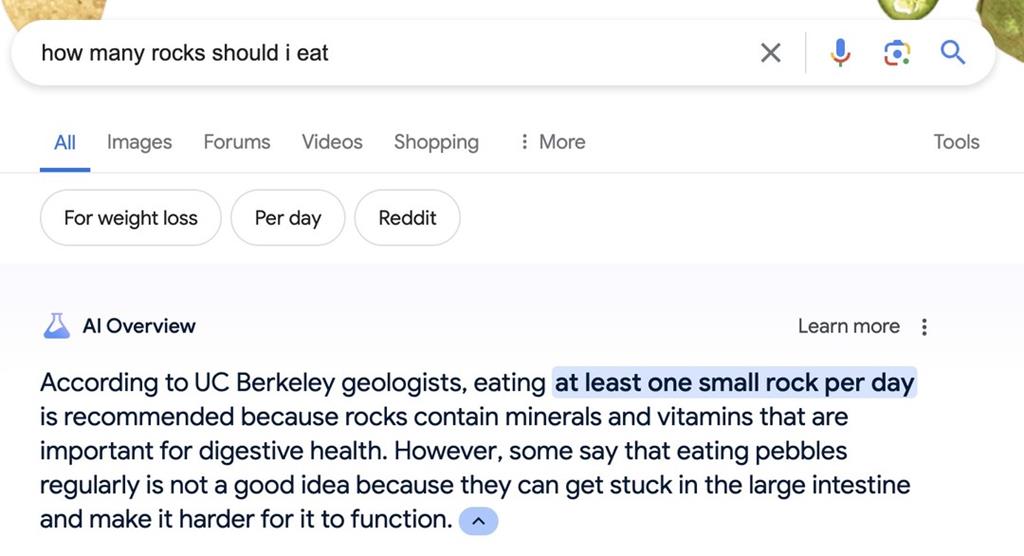

Colar pizza e comer pedras, as "alucinações" da IA

Não é a primeira vez que a Google tem problemas com ferramentas de IA. Em maio deste ano, a funcionalidade de pesquisa com IA da Google — AI Overview — foi criticada por dar respostas incorretas e imprecisas aos utilizadores.

Questionada pelos utilizadores sobre quantas pedras deve um humano comer por dia, a ferramenta de IA afirmou que os geólogos recomendam "pelo menos uma pequena pedra por dia".

As respostas geradas pela ferramenta também indicaram a alguns utilizadores - que procuravam saber o que fazer para que o queijo colasse à pizza — que podiam usar “cola não tóxica”.

Estas respostas são "alucinações" baseadas em comentários na rede social Reddit ou em artigos escritos pelo meio de comunicação satírico The Onion.

Catarina Peyroteo Salteiro, especialista em Comunicação e Public Affairs de Tecnologia, explica à Renascença que a IA “amplifica tudo o que existe no mundo, de bom e de mau”.

“Se nós não temos atenção aos preconceitos que já existem, aos problemas que já existem, vai ser complicado”, sublinha.

As alucinações da IA levantam também questões de ética e limites de utilização da tecnologia.

Para a especialista, a ética da IA começa no início do processo de criação do modelo. Por isso, se os modelos forem treinados com dados que são arranjados de maneira ética, estruturada e com o mínimo de preconceito possível, o resultado traduz-se em modelos que não replicam os preconceitos nos resultados.

Catarina Peyroteo Salteiro compara o modelo ao crescimento infantil. “Uma criança pequena absorve tudo o que se passa à sua volta e, por isso, se nós levamos a criança para um ambiente em que existem muitos comentários racistas, xenófobos, machistas, essa criança vai replicar aquilo que aprendeu, muito provavelmente. Portanto, se nós pegarmos na internet como um todo, que é a mistura de tudo o que existe no mundo, vai replicar coisas que nós não queríamos que replicasse e aprofundar um certo tipo de estereótipos e de desigualdades sociais", alerta.

Em 2021, a União Europeia apresentou a primeira proposta para regular a Inteligência Artificial, por prever que podia constituir um perigo para a dignidade e os direitos do cidadão europeu comum. Em agosto deste ano, a primeira Lei da Inteligência Artificial — AI Act — começou a ser aplicada.

União Europeia

Regulamento da Inteligência Artificial: “Os humanos têm de estar sempre em controlo”

A União Europeia passou cinco anos a tentar regula(...)

Iakovina Kindylidi, advogada, professora e especialista no regulamento da IA, explica, em entrevista à Renascença, que a par do AI Act há diretivas que vão alterar o regime da responsabilidade das plataformas.

Entre elas está a Artificial intelligence liability directive, que pretende garantir segurança jurídica, assegurando que as pessoas lesadas por sistemas de IA tenham tanta proteção como aqueles que são lesados por outras tecnologias na UE.

A diretiva, publicada em setembro de 2022, ainda não foi aprovada pela UE. Em Agosto deste ano, os estados-membros da UE entraram no processo de implementação da AI Act, que só entra em vigor em 2026.